CNN

在图像平整化完全破坏了它的序列,需要一种方式在没有平整haul的情况下把图片馈送给网络,并且还要保留空间排列特征。

- 卷积层:在这一层中,我们定义一个权值矩阵,用来从图像中提取一定的特征。

- 池化层:有时图像太大,我们需要减少训练参数的数量,池化的目的是减少图像的空间大小。池化在每一个纵深维度上独自完成,因此图像的纵深保持不变,常见形式是最大池化。

- 输出层:卷积和池化只会提取体征,并减少原始图像带来的参数。输出层具有类似分类交叉熵的损失函数,用于计算预测误差。一旦前向传播完成,反向出阿伯就会开始更新权重和偏差以达到减少误差的目的。

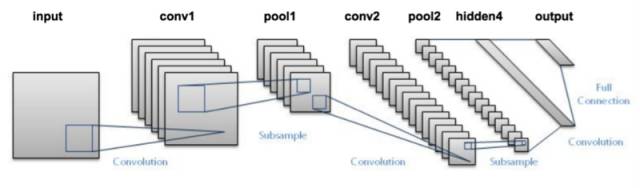

下面是整个网络的样子

CNN 中的输出层是全连接层,其中来自其他层的输入在这里被平化和发送,以便将输出转换为网络所需的参数。随后输出层会产生输出,这些信息会互相比较排除错误。损失函数是全连接输出层计算的均方根损失。随后我们会计算梯度错误。错误会进行反向传播,以不断改进过滤器(权重)和偏差值。